DualNet (NeurIPS 2021)

https://proceedings.neurips.cc/paper_files/paper/2021/file/86a1fa88adb5c33bd7a68ac2f9f3f96b-Paper.pdf

Pham, Quang, Chenghao Liu, and Steven Hoi. "Dualnet: Continual learning, fast and slow." Advances in Neural Information Processing Systems 34 (2021): 16131-16144.

Contents

-

Abstract

- Introduction

- Methodology

- Slow Net

- Fast Net

- Procedure

- Experiments

Abstract

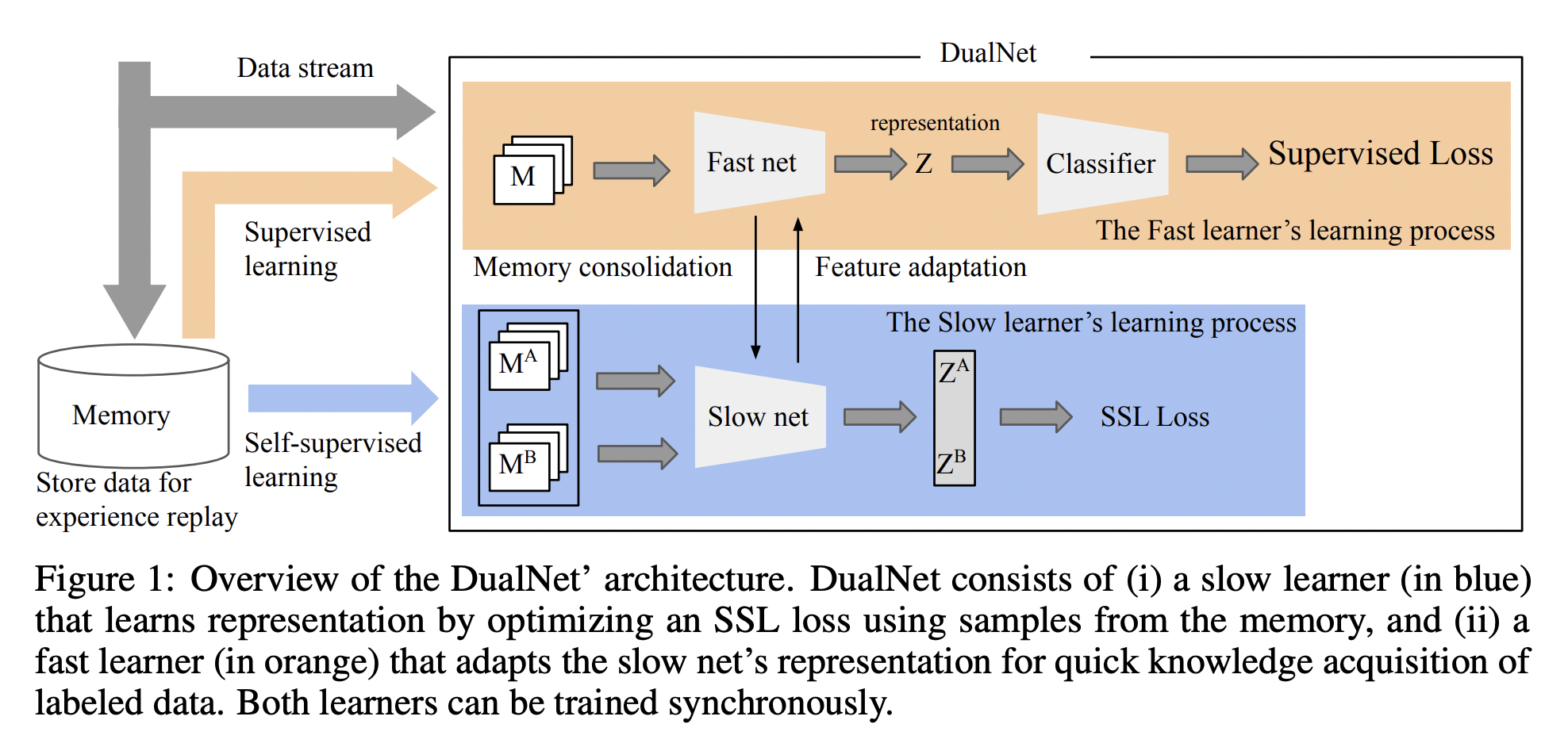

DualNet

- CLS 이론(Complementary Learning Systems)을 기반으로 설계

- 인간의 해마(hippocampus)와 신피질(neocortex) 역할을 모사

- 해마 = 단기 기억

- 신피질 = 장기 기억

- 두 종류의 학습기

- 빠른 학습기 (Fast Learner): Supervised & task-specific

- 느린 학습기 (Slow Learner): Self-supervised & task-agnostic

1. Introduction

인간의 해마 & 신피질

- 해마 (hippocampus): 빠르게 + 특정 에피소드 학습

- 신피질 (neocortex) : 점진적으로 + 일반화된 구조 학습

기존의 Continual Learning (CL)

- 대부분 task-specific 학습기만 존재

DualNet

- CLS 이론을 모델링하여 fast learner + slow learner를 결합

- 두 시스템이 협력하여 이전 task 기억 유지 + 새 task 적응 가능

- SSL 통해 label sparisty 문제 해결

2. Methodology

두 개의 병렬 네트워크로 구성: Fast Learner + Slow Learner

(1) Slow Net

- Self-supervised learning (SSL)을 통해 일반적인 표현을 학습

- SSL 방법론: Barlow Twins

- 학습 데이터: Episodic memory에서 sampling된 unlabeled 데이터

- 특징: Task-agnostic

- 학습한 feature를 Fast learner에게 전달 (i.e., feature adaptation)

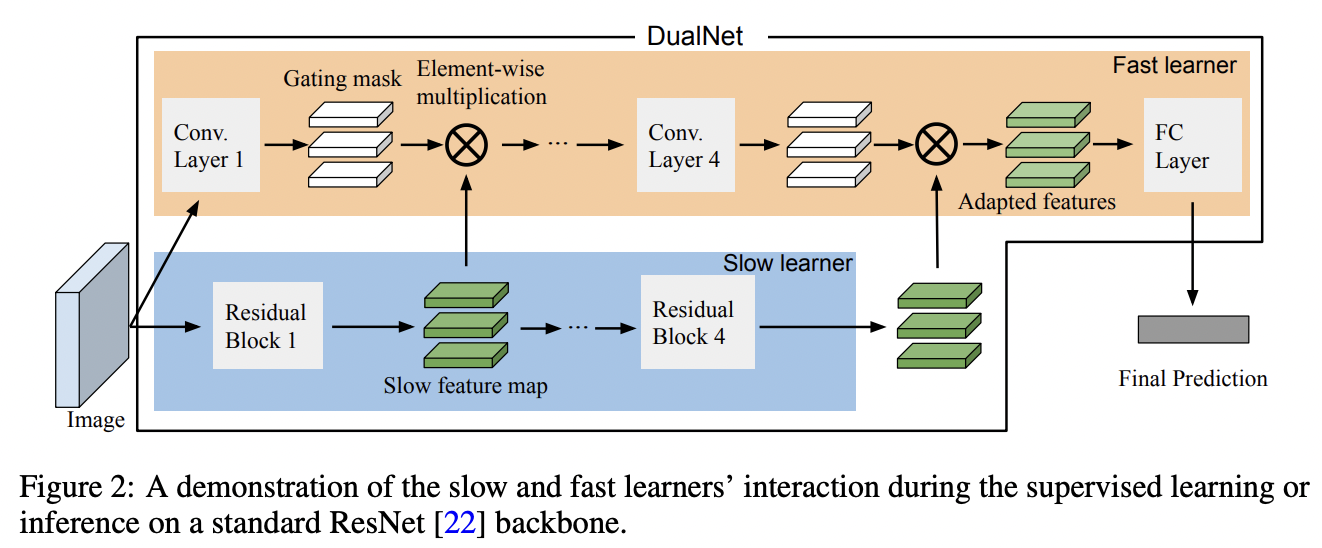

(2) Fast Net

- Supervised Learning 방식으로 현재 task 학습

- Slow learner의 feature를 condition 하여 최종 출력

- Slow feature에 task-specific projection 적용

(3) Procedure

- Step 1) 입력 이미지 → slow learner → feature 추출

- Step 2) fast learner가 그 feature로 예측 → supervised loss 계산

- Step 3) 해당 loss는 fast + slow learner에 모두 backpropagation

- Step 4) unlabeled data는 slow learner에 대해서만 SSL loss로 학습

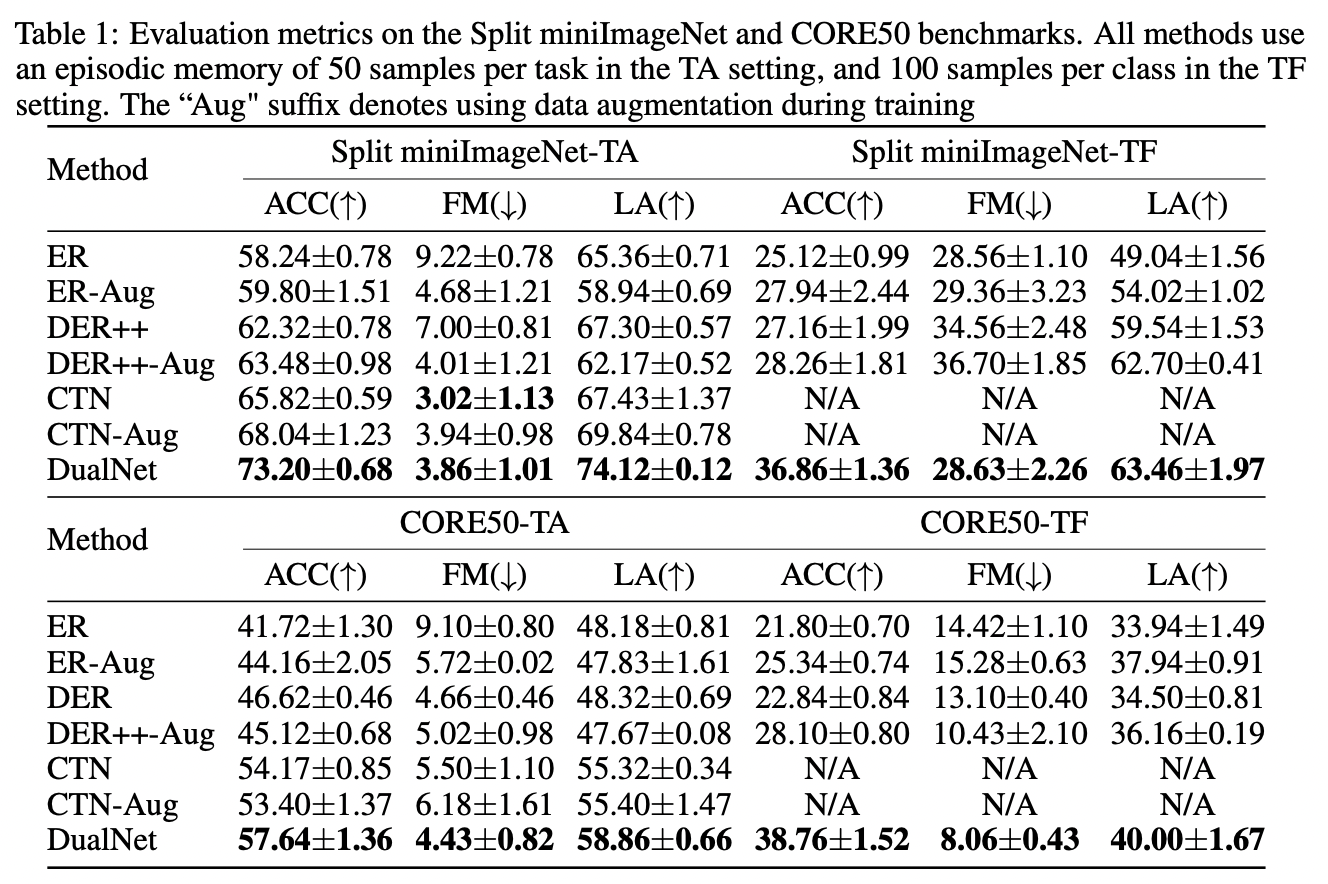

3. Experiments